Implementare explainability nei modelli di computer vision industriale

Implementare l’explainability nei modelli di computer vision industriale: guida approfondita

Introduzione

Nel mondo in rapida evoluzione della tecnologia e dell’automazione, i modelli di visione artificiale stanno rapidamente diventando colonne portanti nei settori produttivi e di controllo qualità. Tuttavia, uno degli aspetti cruciali che spesso rimane in secondo piano è l’explainability nei modelli di computer vision industriale. Questo concetto si riferisce alla capacità di rendere i modelli di visione interpretabili e comprensibili non solo ai tecnici ma anche ai decisori aziendali. Nell’articolo di oggi, esploreremo le tecniche e gli strumenti per ottenere trasparenza e interpretabili modelli di visione in contesti industriali.

Capiremo come l’explainable AI nell’industria possa migliorare la fiducia e l’usabilità dei modelli di computer vision e come questi possano effettivamente fare la differenza nel controllo qualità AI. L’obiettivo è rendere la tecnologia non solo più potente, ma anche più trasparente e affidabile.

Cos’è explainability nella computer vision industriale e perché è importante

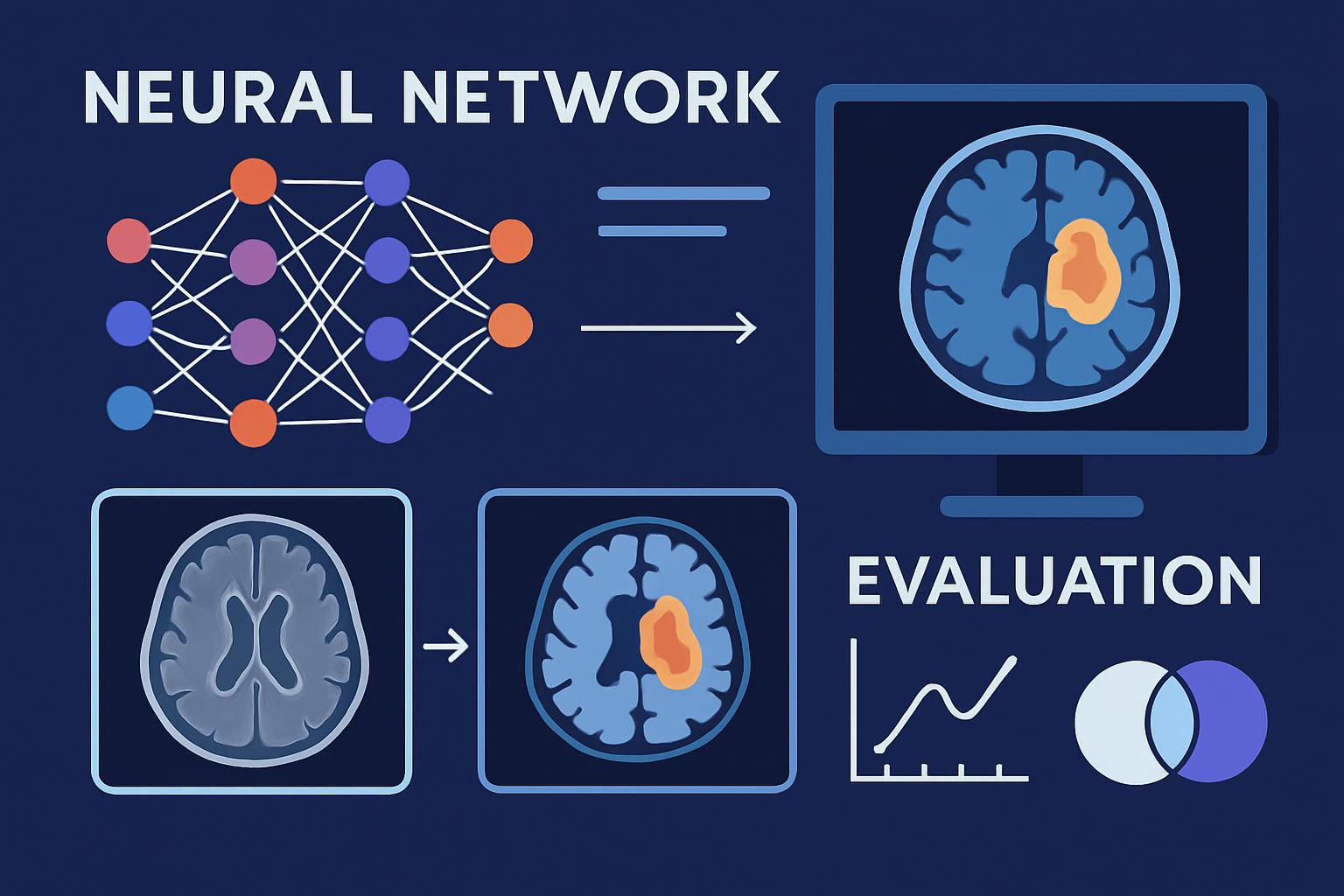

Explainability è un termine che, nel contesto della tecnologia, si riferisce alla capacità di una macchina di spiegare le decisioni o le azioni prese in un linguaggio comprensibile agli esseri umani. Nel campo della computer vision, l’explainability è particolarmente cruciale dato che i modelli sono spesso complessi e agiscono come veri “black box”. Nei settori industriali, la necessità di comprendere come e perché un sistema automatizzato prenda determinate decisioni è fondamentale per garantire l’affidabilità e la sicurezza dei processi produttivi.

Explainable AI (XAI) nell’industria non solo aiuta a migliorare la trasparenza e la confidenza nei sistemi automatizzati, ma è anche cruciale per normative e regolamentazioni che richiedono la spiegabilità delle decisioni prese dalle macchine. Ad esempio, nel controllo qualità, se un sistema di visione computazionale respinge un prodotto come difettoso, le aziende devono comprendere il motivo per giustificare tale decisione ai clienti e ai regolatori.

Come funziona

Rendere un modello di visione artificiale interpretabile richiede diverse tecniche e approcci. Vediamo i passaggi chiave per implementare l’explainability nei modelli di computer vision industriale.

1. Tecniche di interpretazione post-hoc

Queste tecniche sono applicate dopo che il modello ha fatto una previsione e aiutano a spiegare perché il modello ha preso quella decisione particolare:

-

Mappe di calore: Queste visualizzazioni aiutano a identificare quali parti dell’immagine hanno influenzato maggiormente la decisione del modello. Tecniche come Grad-CAM (Gradient-weighted Class Activation Mapping) sono utilizzate per evidenziare queste zone.

-

LIME (Local Interpretable Model-agnostic Explanations): Questa tecnica spiega le previsioni di qualsiasi classificatore black-box individuando il comportamento locale della predizione.

-

SHAP (SHapley Additive exPlanations): SHAP fornisce una spiegazione consistente delle previsioni basata sulla teoria dei giochi, calcolando l’apporto di ciascun pixel dell’immagine alla decisione finale.

2. Modelli interpretabili per natura

Alcuni modelli sono progettati per essere più trasparenti fin dall’inizio:

-

Reti neurali trasparenti: Questi modelli utilizzano architetture che consentono una maggiore introspezione e spiegabilità delle decisioni, come i modelli a base neurale di attentional mechanism.

-

Visione basata su esempi: Invece di selezionare caratteristiche astratte, questi modelli fanno previsioni basate su immagini simili già classificate.

3. Adattamento data-driven

Considerare la spiegabilità già in fase di raccolta e gestione dei dati può migliorare significativamente la spiegazione dei modelli.

-

Pre-elaborazione dei dati: Assicurarsi che i dati siano accuratamente normalizzati e annotati in modo chiaro, può portare a modelli più comprensibili.

-

Esemplificazione controllata degli input: Utilizzare set di dati semplificati per addestrare il modello può migliorare la capacità di spiegazione per le previsioni.

Ogni approccio ha il suo insieme di vantaggi e limitazioni e la scelta della tecnica giusta spesso dipende dalle esigenze specifiche del caso d’uso.

Applicazioni pratiche e casi d’uso

Nell’ambito dell’industria, l’explainability nei modelli di computer vision industriale trova diverse applicazioni pratiche. Vediamo alcuni esempi reali:

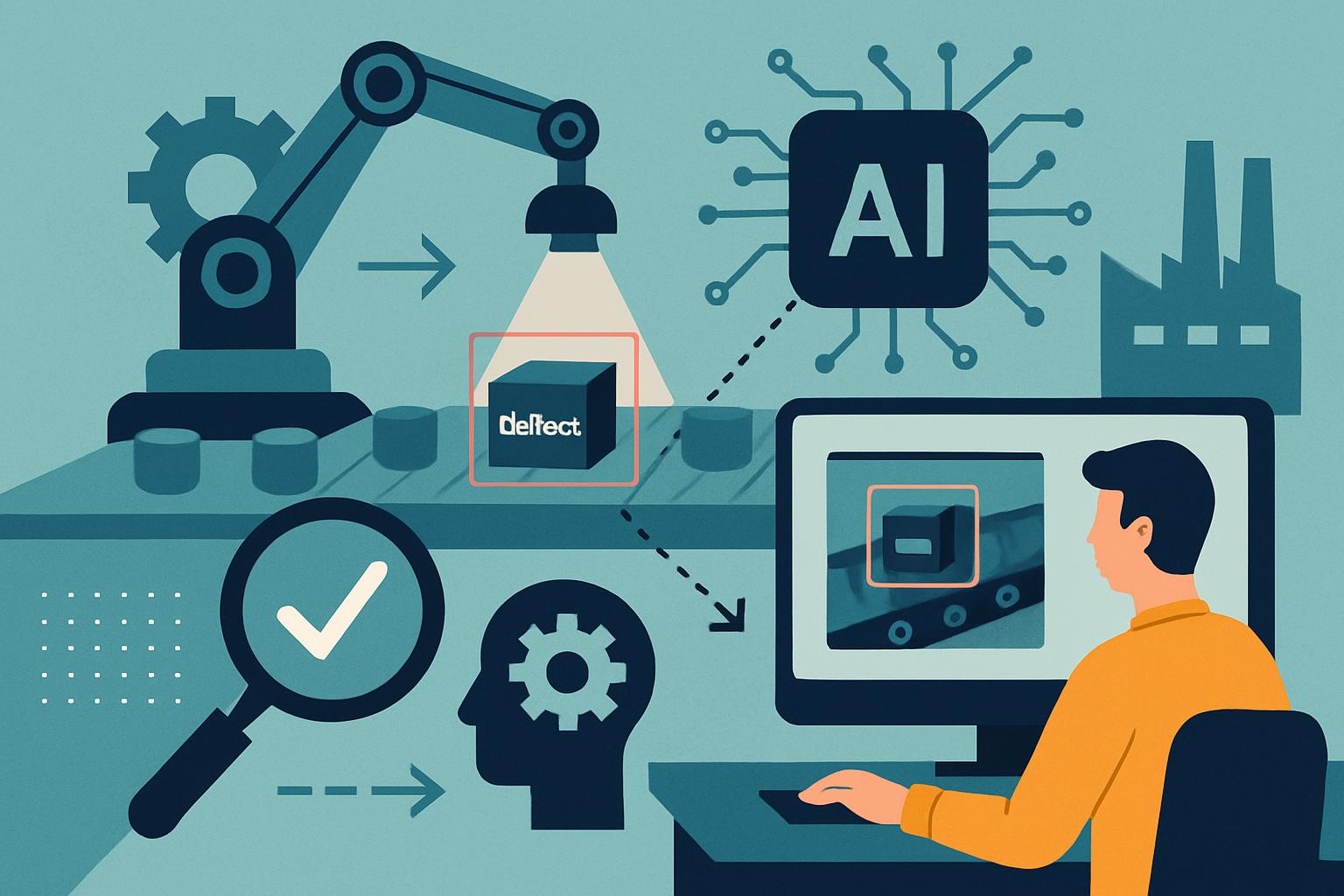

Settore manifatturiero

- Controllo qualità AI: Aziende come BMW e Siemens hanno iniziato ad implementare modelli di visione artificiali per rilevare difetti in tempo reale sulla linea di produzione. La spiegabilità in questo contesto aiuta gli ingegneri a comprendere rapidamente i difetti e ad intervenire in modo efficiente.

Sorveglianza e sicurezza

- Sistemi di sorveglianza: Modelli di computer vision sono utilizzati per rilevare comportamenti anomali o attività sospette. La spiegabilità garantisce che tali sistemi non commettano errori ingiustificati, riducendo falsi allarmi e migliorando la fiducia dei responsabili della sicurezza.

Settore alimentare

- Ispezione dei prodotti: Nell’industria alimentare, i modelli di visione sono utilizzati per controllare la qualità e la sicurezza alimentare. La spiegabilità permette di giustificare rifiuti o accettazioni di lotti di produzione, migliorando così le procedure di controllo.

Vantaggi e sfide

Vantaggi dell’explainability

-

Aumento della fiducia: La trasparenza dei modelli aumenta la fiducia degli utenti finali e dei clienti nei sistemi AI. Avere spiegazioni dettagliate delle decisioni rende i modelli più accettabili, aumentando l’efficacia dell’adozione.

-

Conformità regolamentare: Molte normative richiedono che le decisioni dei modelli AI siano spiegabili, specialmente in industrie regolamentate come quella farmaceutica e alimentare.

Sfide da superare

Privacy

Rendere un modello spiegabile può richiedere di condividere informazioni sensibili sui dati di input, il che potrebbe portare a problemi di privacy. Le aziende devono bilanciare la necessità di explainability con la protezione dei dati sensibili.

Bias

I modelli di AI possono incorporare o amplificare bias presenti nei dati di addestramento. Le tecniche di spiegabilità possono essere utilizzate per identificare e mitigare questi bias, anche se il processo presenta delle complessità significative.

Efficienza

Aumentare la spiegabilità spesso comporta un maggiore utilizzo di calcoli e risorse, il che può influire sull’efficienza operativa dei modelli.

Strumenti e tecnologie collegate

Diverse librerie e strumenti sono a disposizione per aiutare i professionisti a implementare spiegabilità nei loro progetti di visione artificiale.

1. Captum

Captum è una libreria per PyTorch che offre tecniche di interpretazione e spiegabilità per modelli di deep learning. Permette di utilizzare metodi come Integrated Gradients e Gradient SHAP direttamente sui modelli PyTorch.

2. LIME

LIME è un toolkit popolare per creare spiegazioni locali per modelli complessi. Sebbene sia agnostico al modello, trova grande applicazione nella computer vision per creare spiegazioni comprensibili a livello di immagine.

3. SHAP

SHAP è un’altra potente libreria basata sulla teoria dei giochi che fornisce spiegazioni coerenti per le predizioni dei modelli utilizzando il valore di Shapley. Risulta particolarmente utile per modelli di visione artificiale che trattano grandezze complesse.

FAQ

1. Quali sono i principali vantaggi dell’implementazione di explainability nei modelli di computer vision?

L’implementazione di explainability migliora la trasparenza, aumenta la fiducia degli utenti e garantisce la conformità alle normative.

2. Quali tecniche sono le più utilizzate per spiegare i modelli di visione artificiale?

Tecniche popolari includono LIME, SHAP e Grad-CAM, ognuna con approcci unici per interpretare le decisioni dei modelli.

3. L’adozione di modelli interpretabili è più costosa?

Mentre l’adozione di modelli interpretabili può implicare un maggiore investimento iniziale in termini di risorse computazionali e tempo, i benefici a lungo termine in termini di trasparenza e conformità spesso giustificano il costo.

Conclusione

In un contesto industriale in cui l’automazione e l’intelligenza artificiale stanno diventando sempre più prevalenti, l’importanza dell’explainability nei modelli di computer vision non può essere sottovalutata. Mentre i benefici sono evidenti, le sfide non devono essere trascurate. Strumenti e tecniche adeguati consentono di bilanciare efficienza e trasparenza, rendendo i modelli non solo potenti, ma anche interpretabili e affidabili. Invitiamo i lettori a esplorare ulteriormente altri articoli del nostro blog che approfondiscono tematiche correlate e offrono ulteriori spunti per implementare la spiegabilità nei vostri progetti AI.

🤖 L’AI sta rivoluzionando il business. Se non la usi tu, lo farà la concorrenza.

Prenota una call gratuita