Sfruttare il transfer learning per modelli NLP multilingue

Sfruttare il Transfer Learning per Addestrare Modelli NLP Multilingue con Dataset Limitati

Introduzione

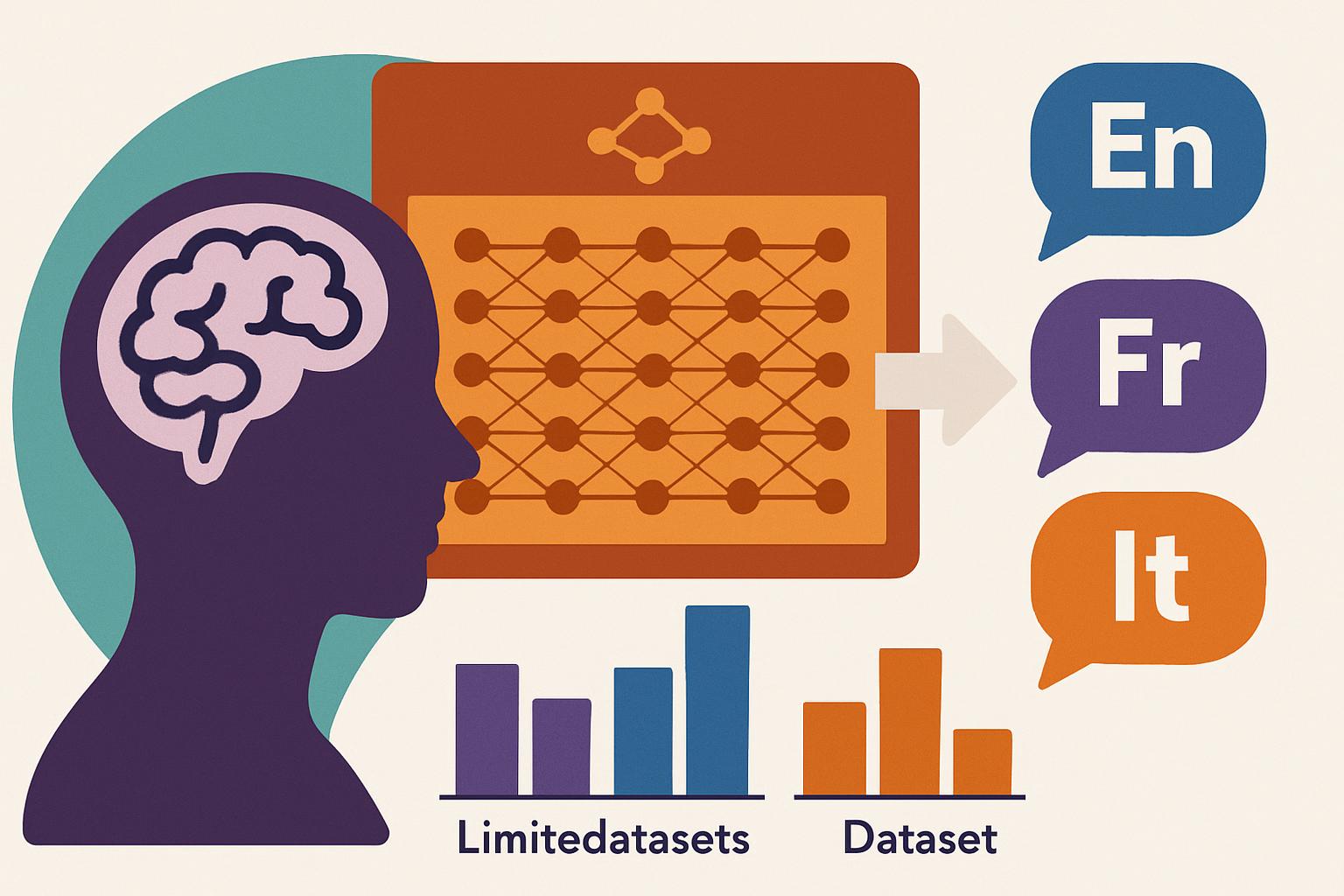

Nell’era della globalizzazione e della comunicazione istantanea, l’elaborazione del linguaggio naturale (NLP) ha assunto un ruolo di primaria importanza nel rendere le tecnologie più inclusive e accessibili a livello globale. Tuttavia, uno dei principali ostacoli che gli sviluppatori incontrano è l’esigenza di addestrare modelli NLP che possano comprendere e produrre testi in diverse lingue, utilizzando dataset spesso limitati e non omogenei. È qui che il transfer learning si rivela uno strumento potente.

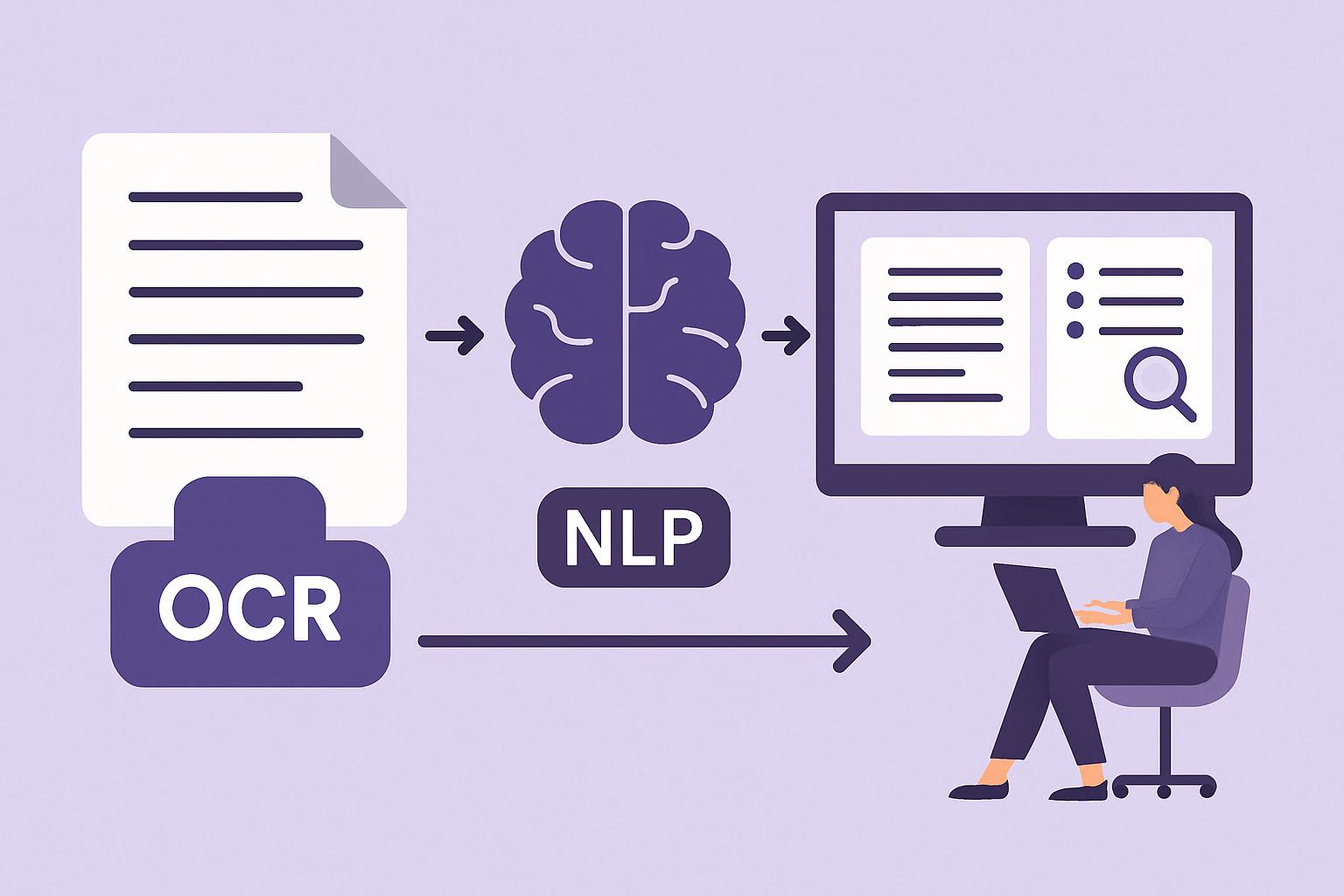

Il transfer learning NLP multilingue si riferisce a una tecnica di apprendimento che consente di trasferire conoscenze acquisite in un contesto linguistico per migliorare le prestazioni di un modello in un altro contesto, spesso con meno dati o risorse. L’obiettivo di questo articolo è delineare le basi del transfer learning multilingue nell’NLP, illustrarne il funzionamento, esplorare le applicazioni pratiche e discutere i vantaggi e le sfide legate a questa tecnologia.

Cos’è il Transfer Learning NLP Multilingue e Perché è Importante

Il transfer learning è un approccio all’apprendimento automatico che permette di utilizzare conoscenze precedentemente apprese in uno specifico dominio o task per migliorare le prestazioni in un dominio o task diverso. Nell’ambito dell’elaborazione del linguaggio naturale, il transfer learning multilingue consente di sfruttare le nozioni contenute in modelli linguistici addestrati su lingue con abbondanti risorse (come l’inglese) per aiutare nello sviluppo di modelli per lingue con minori risorse disponibili (come lingue africane o asiatiche meno diffuse).

Questo approccio riduce notevolmente la quantità di dati necessari per addestrare un modello linguistico efficace in una nuova lingua, migliorando il tempo di sviluppo e riducendo costi e complessità operativa. Ad esempio, un modello pre-addestrato su grandi corpus di testo inglese può essere adattato per lavorare con il cinese o l’arabo, semplicemente con un ulteriore passaggio di addestramento più leggero e mirato. Questa metodologia è fondamentale per creare strumenti di traduzione automatica, assistenti virtuali e altre applicazioni linguistiche in un mondo sempre più interconnesso.

Come Funziona

Il funzionamento del transfer learning NLP multilingue si basa su un procedimento complesso ma ben strutturato, che può essere suddiviso in diversi punti chiave:

-

Pre-training su corpus monolingui di grandi dimensioni: Inizialmente, un modello linguistico viene addestrato su un vasto corpus di dati monolingue. Ad esempio, nel caso dell’inglese, si può utilizzare un corpus composto da miliardi di frasi per permettere al modello di apprendere la struttura della lingua e il significato delle parole.

-

Adozione di architetture di modelli avanzate: Strutture basate su Transformers come BERT o GPT-3 sono comunemente utilizzate per il transfer learning. Queste architetture sono progettate per catturare complessi schemi linguistici e relazioni contestuali attraverso l’attenzione multi-testa e altre innovazioni tecniche.

-

Fine-tuning con dati multilingue o specifici: Una volta che il modello monolingue ha acquisito una competenza di base, viene ulteriormente addestrato (fine-tuned) utilizzando meno dati in una nuova lingua target. Questo processo di affinamento consente al modello di adattarsi rapidamente alle peculiarità della lingua target, come la sintassi, il lessico e le regole grammaticali.

-

Transfer Learning cross-lingua: Qui, la componente multilingua entra in gioco. Il modello è addestrato in modo da condividere caratteristiche e rappresentazioni tra diverse lingue. In questo modo, la conoscenza nelle lingue più risorse può essere trasferita alle lingue meno comuni.

-

Valutazione e feedback loop: Infine, il modello viene testato e validato su un set di dati separato per valutarne le prestazioni. I risultati ottenuti vengono utilizzati per ulteriori perfezionamenti, creando un ciclo continuo di miglioramenti.

Applicazioni Pratiche e Casi d’Uso

Il transfer learning in contesto multilingue ha già trovato implementazioni in numerosi scenari reali, portando vantaggi concreti in vari settori.

-

Traduzione automatica: Servizi come Google Translate fanno largo uso del transfer learning per migliorare la qualità della traduzione tra lingue con risorse diseguali. Modelli di deep learning precedentemente allenati possono tradurre testi con maggiore accuratezza grazie al transfer learning.

-

Assistenti vocali e chatbot: Dispositivi come Amazon Alexa o Siri di Apple integrano modelli di NLP multilingua per riconoscere e rispondere a comandi in diverse lingue. Il transfer learning permette di espandere il numero di lingue supportate senza richiedere massicci investimenti in nuovi dati.

-

Analisi del sentiment a livello internazionale: Le aziende utilizzano modelli di NLP per comprendere le opinioni degli utenti in lingue diverse sui social media. Farmout Technologies, ad esempio, ha impiegato il transfer learning per adattare la sua piattaforma di analisi del sentiment multilingue, migliorando così notevolmente la precisione delle sue previsioni in mercati multilingue.

-

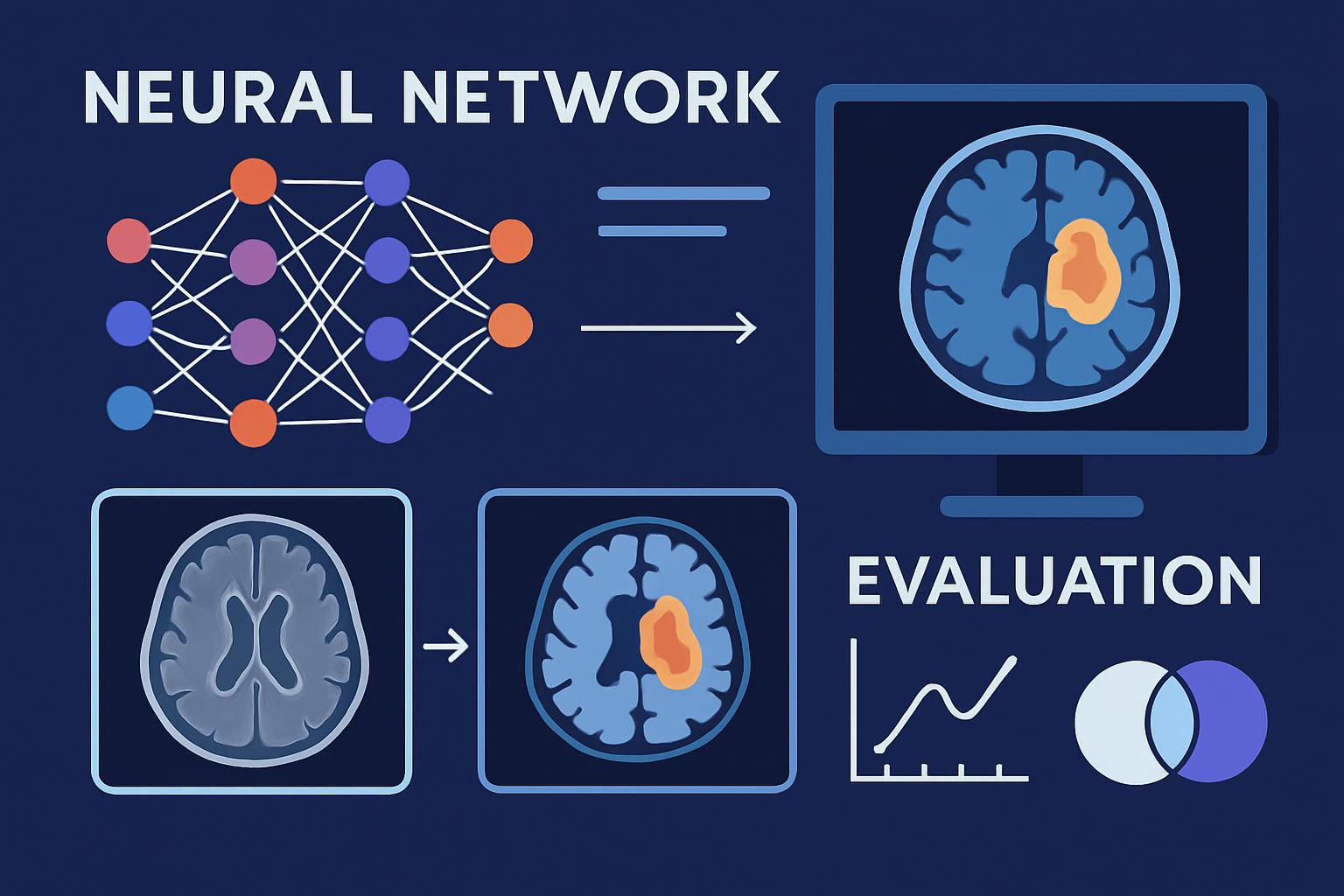

Medicina e documentazione clinica: Il transfer learning permette di adattare modelli linguistici esperti in inglese ad altre lingue per l’analisi di documenti clinici, facilitando la ricerca medica e migliorando la categorizzazione delle diagnosi a livello globale.

Vantaggi e Sfide

Vantaggi del Transfer Learning Multilingue

-

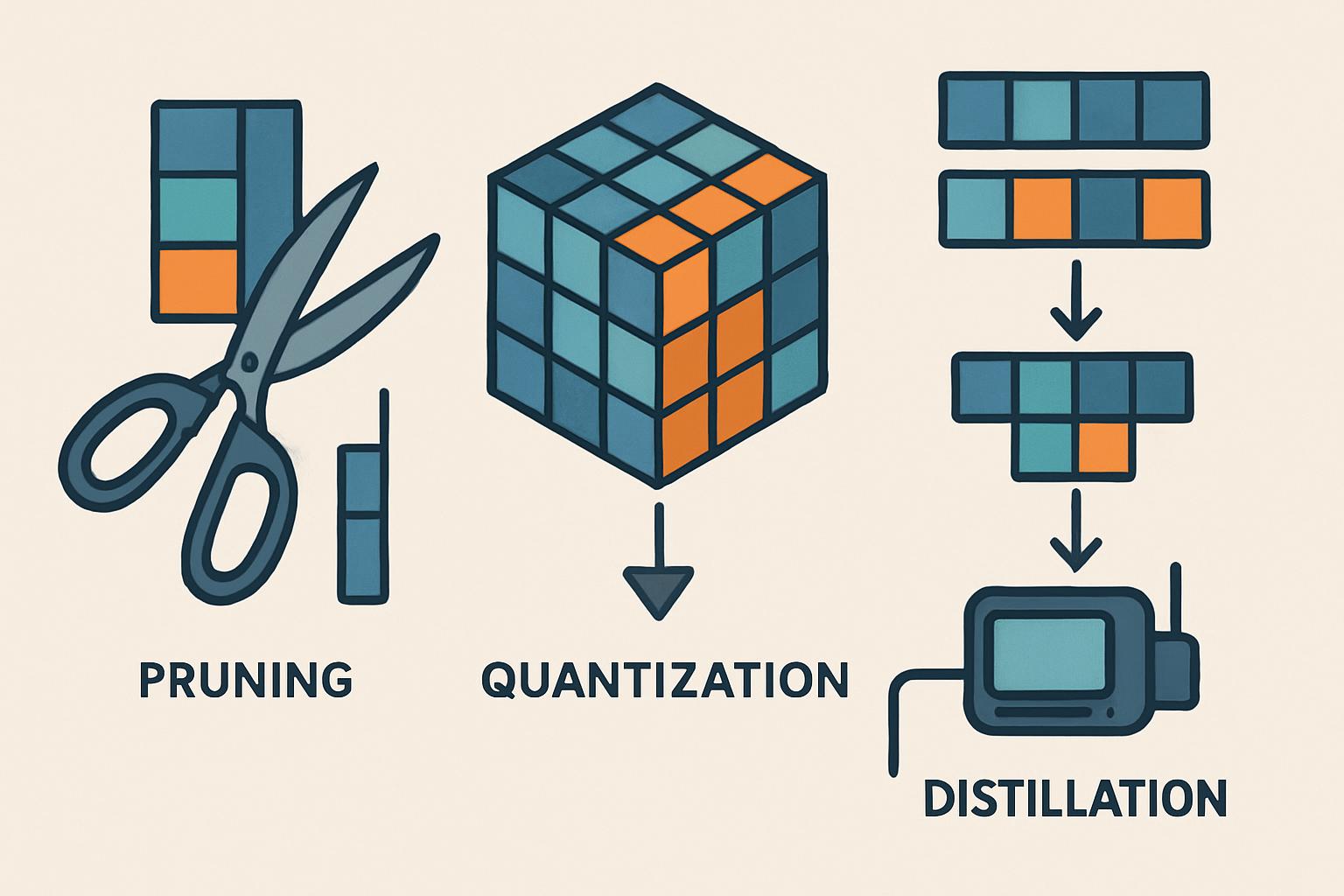

Efficienza dei dati: Permette di addestrare modelli accurati anche con dataset limitati, riducendo la necessità di raccolte di dati estensive e costose.

-

Tempo e costi ridotti: I modelli possono essere adattati più rapidamente a nuove lingue senza richiedere un nuovo ciclo completo di addestramento.

-

Scalabilità: Semplifica l’espansione della copertura linguistica di applicazioni e servizi già esistenti.

Sfide del Transfer Learning Multilingue

-

Bias linguistico: I modelli pre-addestrati su lingue dominanti possono portare contenuti distorti o interpretabili erroneamente quando applicati a lingue meno rappresentate, rendendo necessario un controllo accurato degli output.

-

Limitazioni delle risorse computazionali: L’adattamento e il fine-tuning di modelli di grandi dimensioni richiede una notevole capacità computazionale e risorse tecniche avanzate, che potrebbero non essere accessibili a tutte le organizzazioni.

-

Configurazione del modello: Ciascuna lingua ha peculiarità uniche che possono non essere facilmente catturate da un modello generico, richiedendo quindi personalizzazioni specifiche.

Strumenti e Tecnologie Collegate

-

Hugging Face Transformers: Questa libreria è una delle più popolari per il NLP ed offre modelli pre-addestrati su più lingue che possono essere facilmente utilizzati e adattati, agevolando il processo di transfer learning.

-

Google’s Multilingual BERT: Un modello creato da Google che è stato pre-addestrato su diverse lingue e può essere efficacemente utilizzato per applicazioni multilingue sfruttando la potenza del transfer learning.

-

OpenAI’s GPT-3: Sebbene principalmente noto per le sue capacità di elaborazione in inglese, GPT-3 offre funzionalità sorprendenti in un contesto multilingue grazie alla quantità e varietà di dati su cui è stato addestrato.

FAQ

1. Cos’è il Transfer Learning e perché è utile nell’NLP multilingue?

Il Transfer Learning è una tecnica di machine learning che consente di applicare conoscenze acquisite in precedenti addestramenti a nuovi compiti. È utile nell’NLP multilingue perché permette di sviluppare modelli efficaci per lingue con risorse limitate sfruttando dati e competenze di lingue più diffuse.

2. Quali sono i principali vantaggi del Transfer Learning?

I principali vantaggi includono l’efficienza nei dati, la riduzione dei tempi e dei costi di sviluppo, e una più facile scalabilità delle applicazioni a nuove lingue.

3. Che tipo di modelli si prestano meglio al Transfer Learning per sviluppi multilingua?

Modelli basati su architetture di transformers, come BERT e GPT, si prestano particolarmente bene al Transfer Learning per compiti multilingua grazie alla loro capacità di comprendere e generare testo in diversi contesti linguistici.

Conclusione

In un mondo sempre più connesso, la capacità di comprendere e interagire in più lingue è essenziale per le tecnologie moderne. Il transfer learning NLP multilingue offre soluzioni efficaci per superare le barriere linguistiche, potenziando applicazioni che migliorano il nostro modo di comunicare e interagire a livello globale. Anche se esistono sfide tecniche e di bias, i continui progressi in questo campo promettono un futuro in cui la tecnologia sarà davvero inclusiva e accessibile per tutti, indipendentemente dalla lingua parlata.

Vi invitiamo a esplorare ulteriormente il nostro blog per scoprire di più su come l’intelligenza artificiale sta trasformando il modo in cui interagiamo con la tecnologia e con il mondo.

🤖 L’AI sta rivoluzionando il business. Se non la usi tu, lo farà la concorrenza.

Prenota una call gratuita