Uso di modelli multimodali in agentic app

L’Evoluzione delle App Intelligenti: L’Impatto dei Modelli Multimodali AI nelle Agentic App

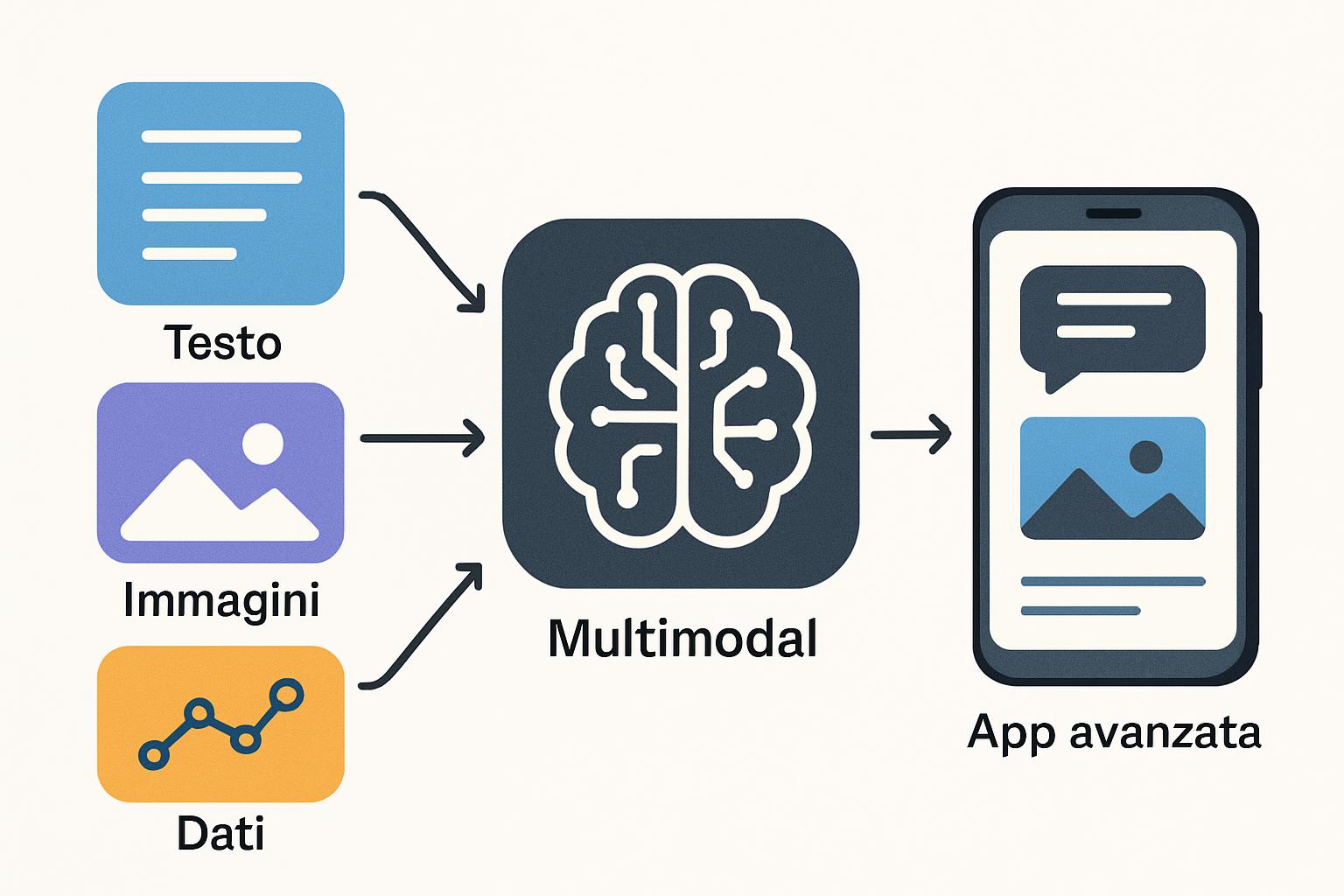

Negli ultimi anni, l’intelligenza artificiale ha fatto passi da gigante, rivoluzionando il modo in cui interagiamo con la tecnologia. Una delle innovazioni più affascinanti in questo campo è l’uso dei modelli multimodali AI. Questi modelli hanno la capacità di combinare simultaneamente dati provenienti da fonti diverse come testo, immagini, suoni e video, creando un ecosistema di intelligenza digitale più ricco e complesso. Le agentic app, o applicazioni in grado di operare autonomamente per supportare gli utenti in vari compiti, beneficiano enormemente di questa tecnologia avanzata.

Cos’è modelli multimodali AI e perché è importante

I modelli multimodali AI rappresentano un approccio all’integrazione dei dati che rispecchia il modo in cui gli esseri umani elaborano informazioni. Gli esseri umani raramente si affidano a un solo tipo di input sensoriale per prendere decisioni. Analogamente, i modelli multimodali permettono alle macchine di comprendere e integrare diverse forme di dati, permettendo un’elaborazione più completa e accurata.

Questo approccio è fondamentale in un mondo in cui i dati sono sempre più disponibili in molteplici forme. Consideriamo un motore di ricerca in grado di rispondere a domande non solo attraverso il testo ma anche riconoscendo immagini o interpretando registrazioni vocali: le possibilità diventano quasi infinite. L’importanza dei modelli multimodali sta nella loro capacità di migliorare la precisione e la versatilità delle AI, aumentando la loro utilità in svariati campi, dall’assistenza sanitaria alla produzione di contenuti fino all’assistenza virtuale.

Come funziona

Per comprendere il funzionamento dei modelli multimodali, vediamo i passaggi fondamentali del processo tecnico alla loro base:

-

Raccolta di Dati Multimodali: I dati vengono raccolti da fonti diverse, ad esempio testo, immagini, audio e video.

-

Preprocessing dei Dati: Ogni tipo di dato viene elaborato per essere convertito in un formato che il sistema può utilizzare. Ad esempio, l’audio potrebbe essere convertito in testo tramite riconoscimento vocale.

-

Rappresentazione Comune: I dati elaborati vengono unificati in una rappresentazione comune che permette al modello di comprenderli come un unico insieme. Questo processo spesso implica la creazione di “embedding” che rappresentano le informazioni multi-formato in uno spazio condiviso di vettori.

-

Integrazione e Apprendimento: Attraverso le reti neurali, il sistema impara a combinare le informazioni in modo utile. Tecniche come “federated learning” possono essere utilizzate per allenare il modello su dati distribuiti senza comprometterne la privacy.

-

Inferenza Multimodale: Una volta addestrato, il modello è in grado di fare inferenze che tengono conto di dati provenienti da diverse modalità, gestendo in modo simultaneo fonti complesse.

-

Feedback e Raffinamento: Il sistema migliora continuamente grazie ai feedback ricevuti dal suo utilizzo nel mondo reale, adeguando i parametri basati su prestazioni e aggiornamenti dati.

Applicazioni pratiche e casi d’uso

La potenzialità dei modelli multimodali AI si estende su molteplici settori e casi d’uso. Ecco alcuni esempi rilevanti:

-

Healthcare: I modelli multimodali aiutano nel diagnosticare condizioni mediche analizzando i dati di immagini mediche, referti storici dei pazienti e segnalazioni audio di sintomi raccolti da dispositivi diagnostici, migliorando l’accuratezza della diagnosi e del trattamento.

-

Content Creation: Attraverso la combinazione di testi, video e immagini, questi modelli possono generare contenuti nuovi e creativi per il marketing digitale, rispondendo a esigenze specifiche degli utenti finali con maggiore precisione.

-

Assistenza Virtuale: I modelli multimodali avanzano le capacità degli assistenti virtuali, come Alexa o Google Assistant, migliorandone la comprensione del linguaggio naturale e l’interazione con l’utente attraverso l’integrazione di più tipi di dati.

Vantaggi e sfide

Vantaggi

-

Precisione e Affidabilità: Combinando più tipi di dati, i modelli multimodali aumentano l’accuratezza delle previsioni e delle risposte, riducendo gli errori e migliorando l’affidabilità delle applicazioni.

-

Flessibilità Applicativa: La possibilità di integrare tipi di dati diversi rende questi modelli estremamente adattabili a un maggior numero di applicazioni, dall’elaborazione del linguaggio naturale alla visione artificiale.

-

Esperienza Utente Migliorata: Gli utenti possono interagire in modi più naturali e fluidi con i sistemi tecnologici, migliorando l’esperienza complessiva.

Sfide

-

Privacy e Sicurezza: L’integrazione di diversi tipi di dati personali solleva preoccupazioni significative in materia di protezione dei dati e violazioni della privacy.

-

Bias e Imparzialità: I modelli multimodali, come qualsiasi sistema AI, sono soggetti a bias nascosti nei dati su cui sono addestrati, il che può portare a risultati ingiusti o errati.

-

Efficienza Computazionale: La complessità dell’elaborazione di dati multimodali richiede una potenza computazionale e risorse significative, il che può essere una barriera all’adozione estesa.

Strumenti e tecnologie collegate

Tra i numerosi strumenti e tecnologie che supportano lo sviluppo e l’implementazione di modelli multimodali AI, eccone tre di rilievo:

-

TensorFlow: Un framework open-source sviluppato da Google che offre supporto per la creazione di modelli di machine learning, comprese le applicazioni multimodali.

-

PyTorch: Utilizzato soprattutto in applicazioni di ricerca e esperimentazione, PyTorch è noto per la sua flessibilità e capacità di gestire modelli multimodali complessi.

-

OpenAI’s CLIP: Un esempio avanzato di un modello multimodale che integra immagini e testi per creare inferenze più sofisticate e versatili, noto per la sua capacità di comprensione del contesto complesso.

FAQ

Cosa sono i modelli multimodali AI?

I modelli multimodali AI combinano dati provenienti da più forme (come testo, immagini e audio) per creare un sistema che elabora queste informazioni simultaneamente, migliorando la capacità di inferenza e l’accuratezza.

Come i modelli multimodali migliorano le agentic app?

Consentendo a queste applicazioni di comprendere ed elaborare dati da più fonti, i modelli multimodali aumentano la precisione, l’efficienza e l’utilità delle agentic app, rendendo l’interazione utente più naturale e ricca.

Quali sono le principali sfide dell’implementazione di modelli multimodali?

Le sfide principali includono la gestione del bias nei dati, protezione e sicurezza della privacy, oltre all’elevata richiesta di risorse computazionali.

Conclusione

I modelli multimodali AI rappresentano un balzo in avanti fondamentale nello sviluppo delle tecnologie basate sull’intelligenza artificiale. Le loro applicazioni nelle agentic app delineano un futuro in cui l’interazione tra uomo e macchina è più fluida, intuitiva e potente che mai. Tuttavia, come con tutte le tecnologie emergenti, è essenziale affrontare le sfide etiche e tecniche che accompagnano queste innovazioni per garantire un impatto positivo e sostenibile. Invitiamo i nostri lettori a continuare a esplorare il mondo dell’AI attraverso i numerosi altri articoli disponibili sul nostro blog, approfondendo argomenti innovativi e scoprendo nuove prospettive tecnologiche.

🤖 L’AI sta rivoluzionando il business. Se non la usi tu, lo farà la concorrenza.

Prenota una call gratuita